Investigadores de inteligencia artificial dijeron el viernes que han eliminado más de 2,000 enlaces web a imágenes sospechosas de abuso sexual infantil de un conjunto de datos utilizado para entrenar herramientas populares de generación de imágenes de IA.

El conjunto de datos de investigación LAION es un índice enorme de imágenes y leyendas en línea que ha sido una fuente para los principales creadores de imágenes de IA como Stable Diffusion y Midjourney.

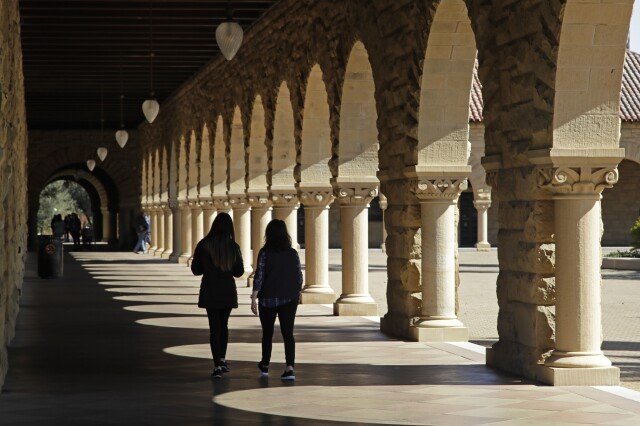

Pero un informe del año pasado del Observatorio de Internet de Stanford encontró que contenía enlaces a imágenes explícitas de niños, contribuyendo a la facilidad con la que algunas herramientas de IA han podido producir deepfakes fotorrealistas que representan a niños.

Ese informe de diciembre llevó a LAION, que significa la organización sin fines de lucro Red Abierta de Inteligencia Artificial a Gran Escala, a eliminar inmediatamente su conjunto de datos. Ocho meses después, LAION dijo en una publicación en el blog que trabajó con el grupo de vigilancia de la Universidad de Stanford y organizaciones contra el abuso en Canadá y el Reino Unido para solucionar el problema y lanzar un conjunto de datos limpio para futuras investigaciones de IA.

El investigador de Stanford David Thiel, autor del informe de diciembre, elogió a LAION por las mejoras significativas pero dijo que el próximo paso es retirar de la distribución los "modelos contaminados" que aún pueden producir imágenes de abuso infantil.

Una de las herramientas basadas en LAION que Stanford identificó como el "modelo más popular para la generación de imágenes explícitas" -una versión antigua y ligeramente filtrada de Stable Diffusion- permaneció fácilmente accesible hasta el jueves, cuando la empresa con sede en Nueva York Runway ML lo eliminó del repositorio de modelos de IA Hugging Face. Runway dijo en un comunicado el viernes que era una "depreciación planeada de modelos e código de investigación que no han sido mantenidos activamente".

La versión depurada del conjunto de datos de LAION llega en un momento en que los gobiernos de todo el mundo están examinando de cerca cómo se están utilizando algunas herramientas tecnológicas para hacer o distribuir imágenes ilegales de niños.

El abogado de la ciudad de San Francisco presentó una demanda a principios de este mes buscando cerrar un grupo de sitios web que permiten la creación de desnudos generados por IA de mujeres y niñas. La presunta distribución de imágenes de abuso sexual infantil en la aplicación de mensajería Telegram es parte de lo que llevó a las autoridades francesas a presentar cargos el miércoles contra el fundador y CEO de la plataforma, Pavel Durov.

El arresto de Durov "marca un cambio realmente grande en toda la industria tecnológica de que los fundadores de estas plataformas pueden ser considerados personalmente responsables", dijo David Evan Harris, investigador de la Universidad de California, Berkeley, que recientemente se puso en contacto con Runway para preguntar por qué el problemático generador de imágenes de IA aún estaba públicamente accesible. Fue retirado días después.